CBDMoE: Consistent-but-Diverse Mixture of Experts for Domain Generalization

Abstract

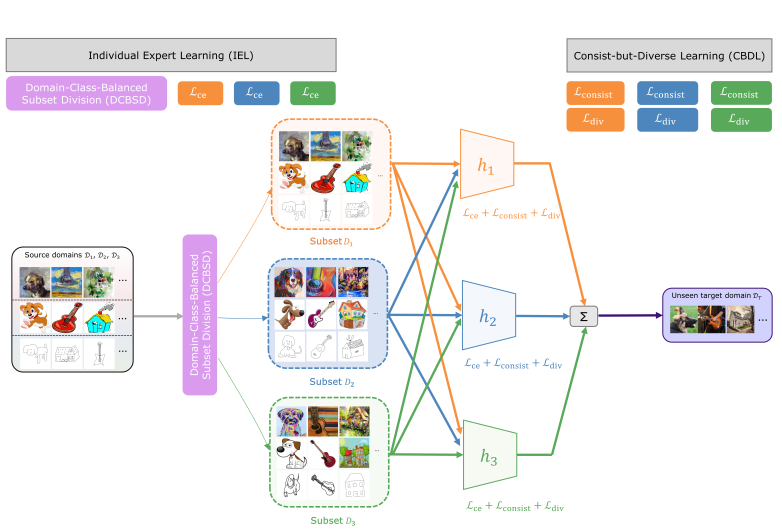

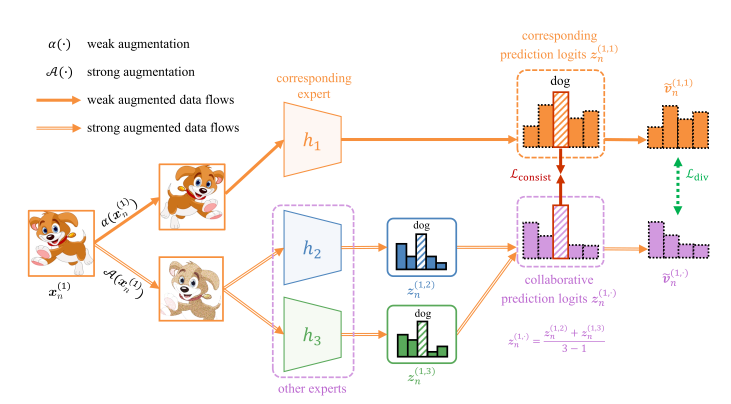

由于测试和训练数据之间的分布变化,机器学习模型经常遭受严重的性能下降。为了解决这一问题,研究人员关注于域泛化(DG),其目的是将在源域上训练的模型泛化到任意未知的目标域。最近,集成学习已经成为解决DG问题的一种流行策略,并且通常涉及特定领域的专家。然而,现有的方法没有充分考虑专家个体的泛化性,也没有充分利用专家之间的一致性和多样性,从而限制了所构建模型的泛化性。在本文中,我们提出了一种一致但多样的混合专家(CBDMoE)算法,这是一种改进的MoE框架,有效地利用集成学习来解决DG问题。具体来说,我们引入了个体专家学习(IEL),它结合了一种新的基于领域类平衡子集划分(DCBSD)的采样策略,以促进可推广的专家学习过程。此外,我们提出了一致但多样的学习(CBDL),它使用两个正则化损失来鼓励专家预测的一致性和多样性。我们提出的策略显著增强了MoE框架的通用性。在三个流行的DG基准数据集上进行的大量实验表明,我们的方法优于最先进的方法

Method