Yunhe Wu, Tong Jia, Xingya Chang, Hao Wang, and Dongyue Chen

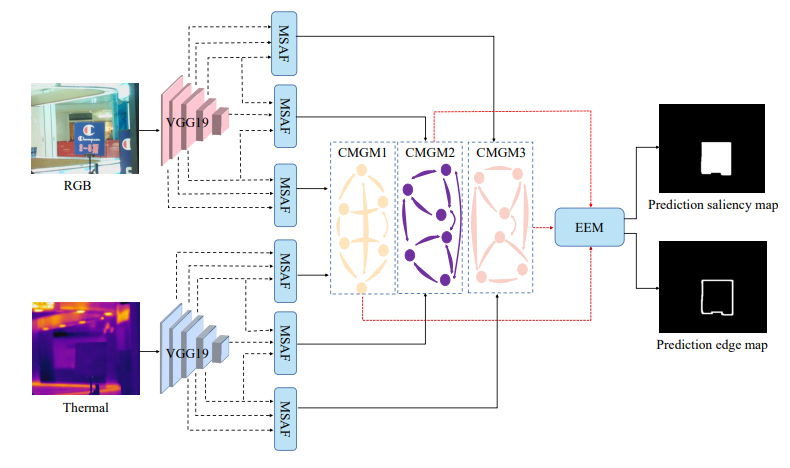

RGB-T saliency detection based on multi-scale modal reasoning interaction

Abstract

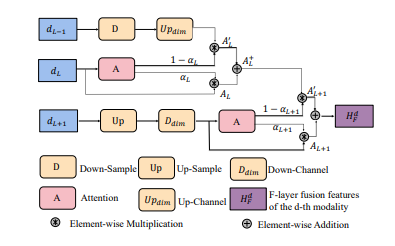

如何探索RGB和热红外模态之间的交互对于RGB-T显著物体检测(SOD)的成功至关重要。大多数现有方法通过从两种模态收集和传递信息来收集和传递信息,而没有探索两种模态之间的隐式关系。为了解决这个问题,我们创新性地提出了一种多尺度模态推理交互网络,通过推断两种模态之间的隐式表达,充分实现两种模态的优势表达和互补融合。具体来说,我们设计了一个多尺度注意力特征提取模块(MSAF),以自适应地平衡浅层图像细节和深层图像语义特征之间的关系,从而增强网络在不同尺度下的特征表示。然后,我们基于图模型设计了一个跨模态交互模块(CMGM),利用图模型的推理能力来探索可见光和红外图像中的互补信息并有效地融合它们。此外,我们提出了边缘增强显著性图生成模块(EEM),以提高显著物体边界的准确性并优化显著性图的生成。大量的实验表明,与最先进的RGBT显著性检测方法相比,我们的方法在所有三个公开数据集上都取得了最佳性能,证明了其在显著性检测任务上的优越性

Method